Onderzoek, ontwikkeling en innovatie

Van deepfakes naar Safe Fakes

Deepfakes, door kunstmatige intelligentie gegenereerde beelden, hebben een slechte reputatie. Toch zijn er wel degelijk nuttige toepassingen te verzinnen voor dit soort nepbeelden. Denk aan de filmindustrie, de medische wereld en in de kunst. Een nieuwe toepassing, ontwikkeld door onderzoekers van de Technisch Universiteit Eindhoven in samenwerking met de Universiteit van Amsterdam, zou wel eens dé uitkomst kunnen zijn voor AI-onderzoek dat gebruik maakt van privacygevoelig beeldmateriaal om algoritmes te trainen. Door Europese privacyregels staat dat soort onderzoek steeds meer onder druk. “Met safe fakes kun je algoritmes trainen met beelden van mensen zonder dat die herkenbaar zijn.”

Voor Sander Klomp, onderzoeker aan de TU/e in de VCA Research groep en ook werkzaam bij TU/e-spin-off ViNotion, begon het als een heel praktisch probleem.

“Bij ViNotion maken we slimme algoritmes waarmee bijvoorbeeld gemeenten kruispunten, waar verschillende verkeersstromen samen komen, in de gaten kunnen houden. Om die algoritmes te trainen, zijn ontzettend veel beelden van voertuigen, fietsers en voetgangers nodig. Dat is met de nieuwe privacyregels van de EU een stuk lastiger geworden. De gezichten zijn namelijk terug te voeren op echte personen, wat volgens de EU in principe alleen mag met hun toestemming.”

De oplossing lijkt simpel. Je anonimiseert de beelden, bijvoorbeeld door de gezichten wazig of korrelig te maken, of door een zwarte balk toe te voegen (zie afbeelding hierboven van Barack Obama). Anders dan bij gezichtsherkenning, is het voor detectie van personen namelijk niet interessant hoe iemand er uit ziet. Het is genoeg dat het algoritme herkent dat het om een mens gaat.

Imagenet

Dit is ook de weg die gekozen is door bijvoorbeeld ImageNet, met ruim 14 miljoen afbeeldingen de grootste en meest gebruikte databank voor AI-onderzoek. Dat besloot in maart 2021 om alle gezichten te ‘blurren’.

“Maar voor ons ligt dat anders,” zegt Klomp. “Wij gebruiken die beelden juist om algoritmen te trainen hoe mensen eruitzien. Als die altijd een waas voor hun gezicht hebben, denkt het algoritme dat mensen er altijd zo uitzien. Je kunt je voorstellen wat dat doet met de nauwkeurigheid van je AI-systemen. Dat moet beter kunnen!”

Deepfakes

Klomp en zijn collega’s dachten meteen aan deepfakes, kunstmatige afbeeldingen of stemmen die zijn gegenereerd door kunstmatige intelligentie. “Door de gezichten op onze beelden te vervangen door willekeurige nepgezichten, kan je de privacy van de betrokkenen beschermen, en tegelijk je detectoren trainen.”

Die oplossing is niet helemaal nieuw, in 2018 is voor het eerst geprobeerd om gezichten te anonimiseren met behulp van deepfakes. Maar het resultaat viel toen nog tegen. Inmiddels zijn de algoritmen om kunstmatig realistische gezichten te genereren, zogenaamde GANs, een stuk beter geworden.

Generative Adversarial Networks, een vorm van machine learning, bestaan uit twee neurale netwerken, die een spel met elkaar spelen. Aan de ene kant heb je een generator, die willekeurig gezichten ‘genereert’, en aan de andere kant een discriminator, die bepaalt of dat gezicht wel voldoende ‘echt’ is.

Dit proces herhaalt zich talloze keren, tot de generator uiteindelijk zo slim is dat deze gezichten kan maken die in niets meer zijn te onderscheiden van een echt gezicht. De beelden kunnen dan worden gebruikt om een gezichtsdetector te trainen.

Deepprivacy

De onderzoekers gebruikten voor hun onderzoek verschillende GAN’s. Uiteindelijk bleek DeepPrivacy, op het moment van het onderzoek het meest geavanceerde algoritme om nepgezichten te genereren, het beste te scoren. Het overtrof niet alleen traditionele manieren om gezichten te anonimiseren (zoals blurren), maar ook andere GAN’s.

“We zien in onze tests dat detectoren die zijn getraind met de nepgezichten van DeepPrivacy een detectiescore halen van rond de 90 procent. Dat is slechts 1 tot 3 procentpunt minder dan detectoren die zijn getraind op niet-geanonimiseerde gegevens. Nog altijd heel goed, zeker als je in aanmerking neemt wat het alternatief is: helemaal geen data meer kunnen gebruiken vanwege de privacyregels.”

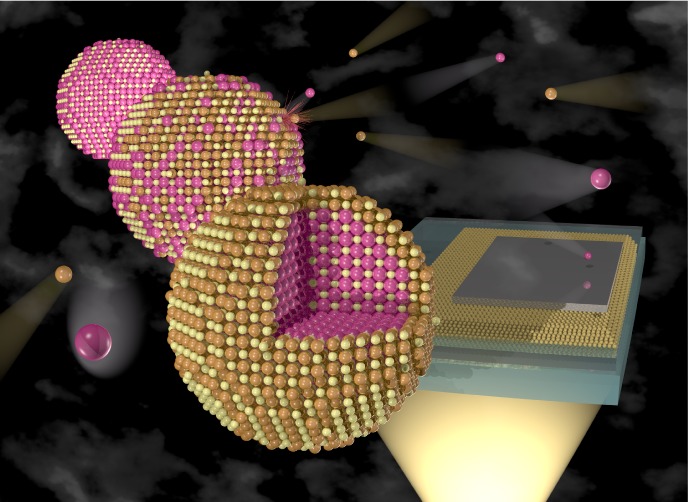

De reden dat trainen op DeepPrivacy beelden zoveel beter werkt dan met oudere GAN’s, is dat het minder keypoints nodig heeft (zie afbeelding).

Klomp: “Keypoints zijn punten die kenmerkend zijn voor het gezicht, zoals de positie van de ogen of de oren. De anonimisator detecteert die voor elk gezicht, en maakt dan de rest van het gezicht zwart, zodat het onherkenbaar wordt. Daarna ‘plakt’ de generator er een nieuw fictief gezicht op. DeepPrivacy gebruikt in totaal maar zeven keypoints, waardoor het zelfs gezichten kan anonimiseren van maar 10 pixels groot.”

De onderzoekers zijn heel tevreden over het resultaat, omdat zij als eerste hebben laten zien dat je goede gezichtsdetectoren kan trainen op beelden die zijn geanonimiseerd met deepfakes.

Ze willen DeepPrivacy, of eventuele opvolgers van deze GAN, dan ook gebruiken om de data van ViNotion te anonimiseren.

Klomp: “Het mooie is dat onze methode ook gebruikt kan worden door onderzoekers die helemaal niet zijn geïnteresseerd in gezichtsdetectie. Denk aan een camera op een zelfrijdende auto, die andere auto’s moet kunnen herkennen. Op die beelden staan vaak ook herkenbare mensen. Die kun je natuurlijk anonimiseren door ze te blurren, zoals ImageNet doet, maar dan lever je toch in op precisie. Onze methode werkt dan beter.”